Transformer:注意力机制(attention)和自注意力机制(self-attention)的学习总结_注意力机制和自注意力机制-CSDN博客 注意力机制的通俗理解 注意力机制其实是源自于人对于外部信息的处理能力。由于人每一时刻接受的信息都是无比的庞大且复杂,远远超过人脑的处理能力,因此人在处理信息的时候,会将注意力放在需要关注的信息上,对于其他无关的外部信息进行过滤,这种处理方式被称为注意力机制。 非自主提示和自主提示 针对于注意力机制的引起方式,可以分为两类,一种是非自主提示,另一种是自主提示。 其中…

前言 搞定了LSTM理论之后,按照理解搭建了一个简易的模型,但是在一切都看起来没什么问题的情况下,报错了。 报错不太寻常,因为并不是跑一轮就报错,而是正常跑几轮才会报错。 用异常捕获机制强制停止出现异常的轮次,打印发现模型输出包含nan的张量。 漫长的debug就这样开始了。 神经网络传播过程中nan的处理 如果神经网络设计有缺陷,确实可能出现传播过程中出现nan的情况,而且这种情况在网络上非常常见。 比如:PyTorch训练过程中出现NaN的排查笔记 - 知乎 我觉得就排查的非常好,非常有条理。 神经网络传播过程…

貌似mac支持了pytorch的显卡调用功能,通过以下函数进行启用 import torch def setup_device(force_cpu=False): if force_cpu: return torch.device("cpu") if torch.cuda.is_available(): return torch.device("cuda:0") if torch.backends.mps.is_built(): return torch.device(&qu…

view tensor.view()方法可以调整tensor的形状,但必须保证调整前后元素总数一致。view不会修改自身的数据,返回的新tensor与原tensor共享内存,即更改一个,另一个也随之改变。 import torch as t a=t.arange(0,6).view(2,3) print(a) b=a.view(-1,2) #当某一维是-1时,会自动计算它的大小 print(b) #输出 tensor([[0, 1, 2], [3, 4, 5]]) tensor([[0, 1], [2, 3], […

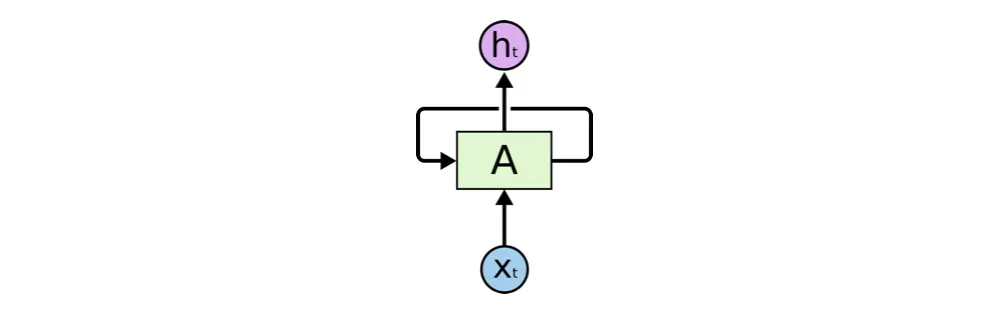

2024.10.24 前言 最近师门在搞序列预测的东西,准备用LSTM来处理一批眼部追踪数据,因此需要学习一下,至少得弄出一个demo出来,看看LSTM好不好使。 本文阅读要求:至少对神经网络有一定的基础,反向传播,DNN这种都应该完全能理解掌握才行。本文不会展开讲公式,主要是应用为主,涉及到一些个人理解和具象化,如有偏颇请指正,感谢理解! 循环神经网络(Recurrent Neural Networks) 由于LSTM是RNN的一种变种,因此理解LSTM需要先了解RNN 人对一个问题的思考不会完全从头开始。比如你…